Repurposing obsahu powered by ai

1 nahrání,

Více než 60 textových formátů.

Vytvářejte 10x rychleji.

Unifire převádí audio, text a video obsah do čehokoli od tweetů, příspěvků na LinkedIn a bulletinů až po blogové příspěvky s 8,000 XNUMX slovy. Všichni jsou vyškoleni na vašem tónu a styl.

Běží na: OpenAI

Antropický

Antropický

Připojte se k tvůrcům obsahu, jako jste vy, a vyhrajte hru o změně účelu.

repurpose versus Generování obsahu

Obsah z ChatGPT vám nefunguje?

Nezaujali vás generičtí autoři AI?

Umělá inteligence zatím nevyřešila žádný problém kromě vytváření velkého množství odpadkového obsahu na vysoké úrovni. Všichni jsou stále zavaleni, mají příliš mnoho povinností a akceptují kvantitu před kvalitou. Nemusí to tak být.

S Unifire nevytváříte od začátku, ale škálujete své stávající výtvory obsahu.

Vytvářejte pracovní postupy obsahu bez rychlého inženýrství.

Přejděte od nahrání ke konečnému obsahu bez nekonečného opakování a ladění. Unifire automatizuje většinu kroků a umožňuje přidat kontext tam, kde je potřeba.

Jeden jednotný pracovní postup.

Vytváříme systémy, které vám pomohou škálovat váš obsah, od nahrávání, přepisu, vlastních pokynů, schvalování přepisu a výběru šablon obsahu až po finální generování obsahu.

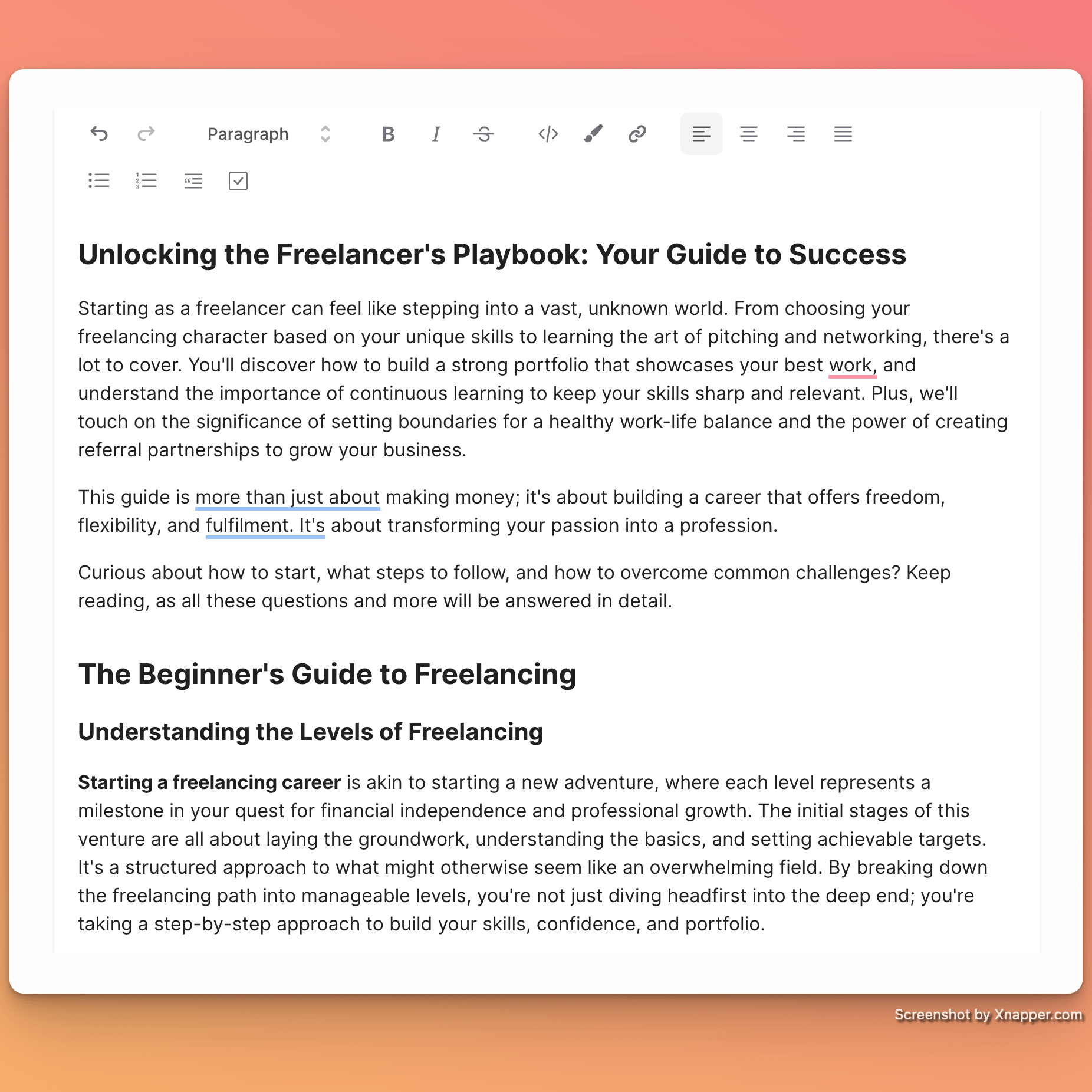

Šablony místo výzev.

Unifire umístí váš obsah do nejlepších šablon pro tvůrce a umožní vám je vést pomocí vlastních pokynů. To snižuje počet pokusů a omylů a umožňuje vám soustředit se na úpravu finálního díla.

Plně kolaborativní zážitek.

Upravujte osnovy, přepisy a konečný obsah společně se svým týmem. Používejte neomezené pracovní prostory, žádná omezení pro členy týmu a žádné ceny podle sedadla.

Znovu použít místo generování

Unifire zůstává na vašem obsahu a odkazuje pouze na to, co vložíte. Používáme jazykové možnosti generativní umělé inteligence, ale méně je to generační.

Věci, které můžete dělat s Unifire, abyste bojovali proti šílenství obsahového marketingu

přepisy Unifire,

extrahuje nápady,

vytváří obrysy

a generuje obsah.

Vyberte si z více než 32 formátů obsahu.

Jedno nahrání můžete změnit na příspěvky na sociálních sítích, extrahovat podcasty a zdroje na YouTube, napsat newsletter, dlouhý článek na blog nebo dokonce elektronickou knihu a váš zdrojový materiál bude plně využit.

Nahrajte a přepište zdrojový materiál.

Nahrajte text, zvuk a video do Unifire. A před generováním obsahu upravujte a schvalujte své přepisy.

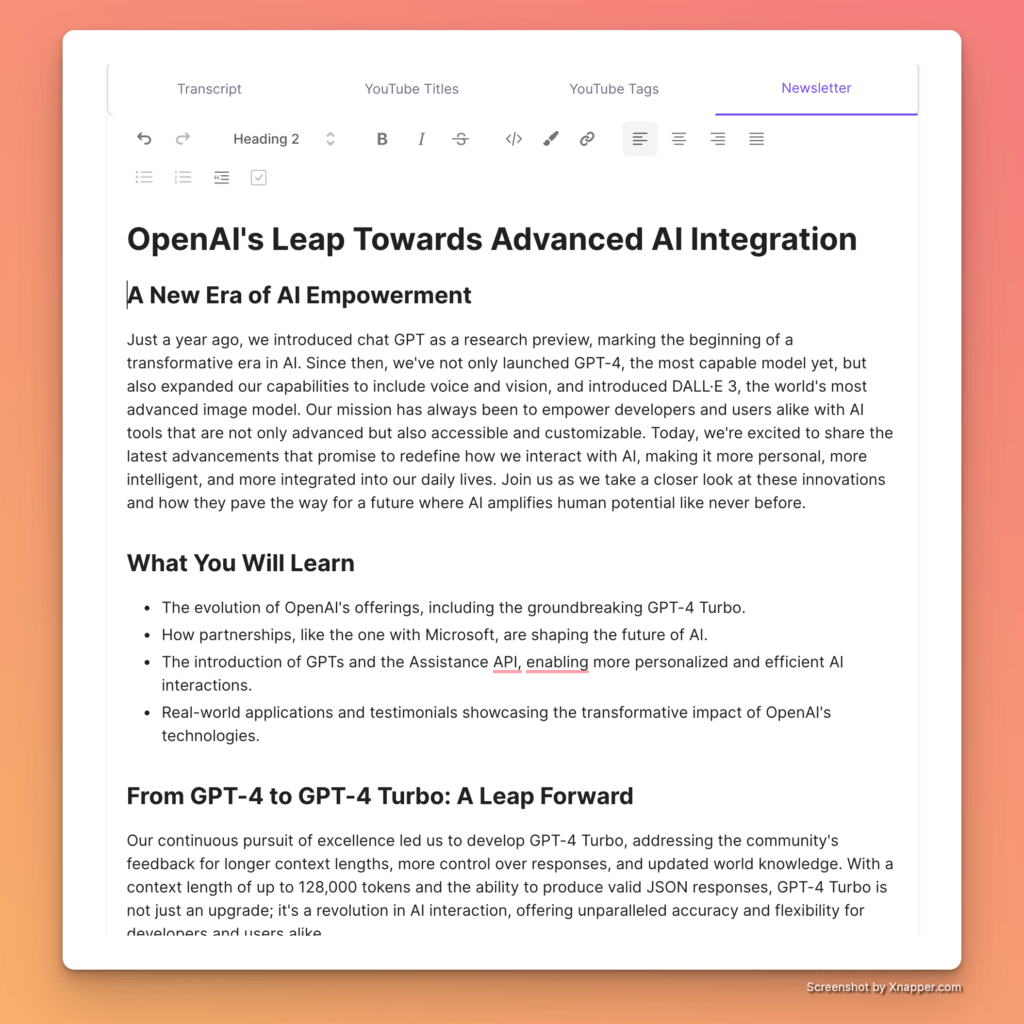

Plně spolupracující editor AI

Jakmile je váš obsah vygenerován, můžete jej upravovat, sdílet a spolupracovat s co největším počtem lidí.

Máte otázky týkající se změny obsahu pomocí Unifire?

Zaměřte se na kvalitu, kreativitu a hodnotu obsahu.

Pokud můžete škálovat jakýkoli obsah, množství již není problém. Zaměřte se tedy na několik základních kamenů a zbytek nechte na Unfire.

Unifire vs. obsahový stres

Rozlučte se s mnoha manuálními kroky a zaměřte se na růst svého podnikání. Našimi klienty jsou konzultanti, malé marketingové týmy, tvůrci obsahu a zakladatelé startupů. Nemohou být všude, ale můžeme se pokusit, aby to bylo trochu méně bolestivé.

العربية

العربية Čeština

Čeština Dansk

Dansk Nederlands

Nederlands English

English Suomi

Suomi Français

Français Deutsch

Deutsch Italiano

Italiano 日本語

日本語 한국어

한국어 Norsk bokmål

Norsk bokmål Polski

Polski Português

Português Русский

Русский Español

Español Svenska

Svenska